Digitale Zeitenwende?

1. Verortung in der Polykrise

2025 markiert einen Wendepunkt: Während die Welt über geopolitische Krisen debattiert, vollzieht sich eine technologische Transformation, deren Wucht alles bisher Dagewesene überlagern wird.

Wir erleben den Übergang von der Phase der “digitalen Entdeckung” (2023–2024) zur “systemischen Industrialisierung” algorithmischer Intelligenz (2026–2030). Die These dieses Artikels ist simpel, aber unbequem: Wer die aktuelle Entwicklung nur als Effizienzsteigerung missversteht, übersieht die tektonischen Verschiebungen, die gerade unser Wirtschaftsmodell und unsere digitale Infrastruktur neu formen.

2. Vom Scheitern einer Utopie bis zu KI

Um die Tragweite der kommenden Jahre zu verstehen, lohnt ein Blick zurück. Die Vision des Global Village , einst von Marshall McLuhan geprägt und von Pionieren wie John Perry Barlow in der “Unabhängigkeitserklärung des Cyberspace” (1996) idealisiert, versprach eine Demokratisierung des Wissens.

“We will create a civilization of the Mind in Cyberspace. May it be more humane and fair than the world your governments have made before.” (Barlow, 1996 )

Diese Utopie ist faktisch gescheitert. Statt einer dezentralen “Zivilisation des Geistes” entstand eine zentralisierte Ökonomie der Aufmerksamkeit. Jaron Lanier entlarvt in “Ten Arguments for Deleting Your Social Media” die systematische Verhaltensmodifikation durch Algorithmen: “BUMMER-Plattformen” (Behaviors of Users Modified, Made into Empire for Rent) manipulieren Aufmerksamkeit für kommerzielle Interessen.

Heute akkumulieren Einzelpersonen wie Elon Musk mehr Macht über kritische Infrastrukturen (Satellitenkommunikation, Raumfahrt, Social Media, Brain-Computer-Interfaces) als manche Nationalstaaten. Peter Thiel, Mitgründer von PayPal und Investor hinter Überwachungstechnologie (Palantir ), propagiert in Zero to One Tech-Monopole als Staatsersatz. Libertäre Milliardäre finanzieren Feinde demokratischer Institutionen . Die neue US-Sicherheitsstrategie , als “Scheidungspapier” bezeichnet, greift Europa scharf an und schreibt “America First” fest.

Diese Machtkonzentration ist kein Zufall, sondern das Ergebnis eines systematischen Scheiterns: Die ursprünglichen humanistischen Ziele der digitalen Revolution wurden durch ein Geschäftsmodell korrumpiert, das auf Überwachung, psychologischer Manipulation und der gezielten Steuerung medialer Narrative basiert.

Während wir das Scheitern der Web-2.0-Utopie noch verarbeiten, rollt mit der KI-Transformation bereits die nächste Welle an – und diesmal geht es nicht allein um die Distribution von Inhalten, sondern um die Produktion von Realität.

3. Metamorphose der Softwareentwicklung (2025–2030)

Die Softwareentwicklung dient für die neue Transformationsphase als “Kanarienvogel in der Kohlemine”. Sie ist der erste Wissenssektor, der vollständig digitalisiert und nun automatisiert wird. Was hier geschieht, blüht Rechtsabteilungen, dem Marketing und der Verwaltung zeitversetzt.

Die Datenlage: Exponentielle Adaption

Die Adoption verläuft exponentiell: 2023 nutzten 36% der Entwickler KI-Assistenten aktiv, 2024 waren es bereits 63% – und aktuelle Analysen zeigen , dass Ende 2025 bereits 76% der professionellen Entwickler KI-Tools nutzen oder deren Einführung planen. Gartner prognostiziert , dass bis 2028 90% der Enterprise Software Engineers KI-Code-Assistenten verwenden werden. Insgesamt findet man verschiedene Ergebnisse, aber die Tendenz ist klar: KI wird zunehmend standardisiert und automatisiert weite Teile der Softwareentwicklung.

Die State of AI 2025 Survey zeigt, wie tief KI bereits in den Arbeitsalltag eingebettet ist: 46% der Entwickler nutzen KI mehrmals täglich für Code-Generierung. Die messbaren Produktivitätsgewinne sind erheblich: Studien dokumentieren , dass Tools wie GitHub Copilot die Geschwindigkeit bei Programmieraufgaben um bis zu 56% steigern.

Das bedeutet: KI wandelt sich vom separaten Tool zu einer “unsichtbaren Schicht” die die Entwicklungsumgebung umfasst.

Die ontologische Transformation: Disposable Software

Man kann sagen, dass die Softwareentwicklung gerade ihrer eigenen industriellen Revolution ausgesetzt ist. Das verändert auch das Wesen und die Funktion von Software selbst. Software wandelt sich von einem (mehr oder weniger) beständigen Asset (“Hausbau”) zu einem fluiden Prozess (“Strom”). Wenn die Herstellungskosten für Code gegen Null tendieren, entsteht das Phänomen der “Disposable Software”:

Applikationen werden Just-in-Time für spezifische Probleme generiert und nach Gebrauch verworfen. Dieses Szenario ist in einzelnen Bereichen bereits Realität.

In einem solchen Szenario wird die reine Beherrschung von Syntax (Java, Python) zweitrangig, bzw. sie verliert ihren Wert. Die neue Währung ist “Hybrid Intelligence”: Die Fähigkeit, etwa Multi-Agenten-Systeme zu orchestrieren.

Doch Vorsicht vor überzogenem Hype: Die State of AI 2025 Umfrage zeigt, dass 69% der Entwickler weniger als 25% ihres Codes mit KI generieren – nur 8% schaffen mehr als 75%. Wir sind noch weit von einer flächendeckenden KI-Code-Generierung entfernt. Heute zählt auch noch Syntax-Kenntnis.

Das zentrale Risiko derzeit: Wir bauen massive “Trust Debt” auf. Die gleiche Umfrage belegt, dass 76% der Entwickler gegenwärtig mindestens die Hälfte des KI-generierten Codes refactorn müssen, bevor er produktionstauglich ist. Die Kosten verschieben sich: weg von der Code-Erstellung, hin zu Validierung und Qualitätssicherung. Was nach Effizienzgewinn aussieht, ist derzeit oft eine Verlagerung systemischer Komplexität.

Kollaps des SaaS-Geschäftsmodells: Von “Per-Seat” zu “Per-Outcome”

Die Transformation der Software-Entwicklung zieht eine ebenso radikale Neuordnung der Software-Ökonomie nach sich. Das traditionelle SaaS-Modell – Abrechnung pro Nutzer-Lizenz (“Seat”) – steht vor dem systematischen Kollaps.

Die Logik ist brutal einfach: Wenn ein KI-Agent die Arbeit von zehn Mitarbeitern übernimmt, kannibalisiert der Anbieter sein eigenes Umsatzmodell, wenn er weiterhin pro Kopf abrechnet. Die Effizienzsteigerung, die KI verspricht, ruiniert die Einnahmen derjenigen, die sie ermöglichen.

Die Konsequenz: Ein fundamentaler Shift zu Outcome-Based Pricing – Abrechnung nach messbaren Ergebnissen wie gelösten Support-Tickets, qualifizierten Leads oder abgeschlossenen Projekten. Software wandelt sich von der passiven Plattform zum “Service-as-Software”: Autonome Agenten führen Aufgaben end-to-end aus, Anbieter stellen nicht mehr nur die Tools dafür bereit.

Gleichzeitig bricht die Margenstory zusammen: Traditionelle SaaS-Unternehmen genossen Bruttomargen von 80-90%. KI-basierte Software drückt diese auf 50-60%, da massive variable Kosten für Compute-Power und Token-Verbrauch entstehen. Dies erzwingt hybride Modelle aus Basisgebühr und verbrauchsabhängigen “Credits”.

Ein extremes Szenario: Das “One-Person Unicorn”. Ein einzelner “Produkt-Architekt” orchestriert 2030 eine Flotte spezialisierter KI-Agenten (Marketing, Sales, Development) und erreicht damit die Wertschöpfung, für die früher ganze Abteilungen nötig waren. Die Hebelwirkung pro Mitarbeiter explodiert – mit unabsehbaren Konsequenzen für Arbeitsmarkt, Wettbewerbsfähigkeit und Unternehmensstrukturen.

Strukturelle Arbeitsmarkt-Disruptionen

AI SLOP 1 via Gemini

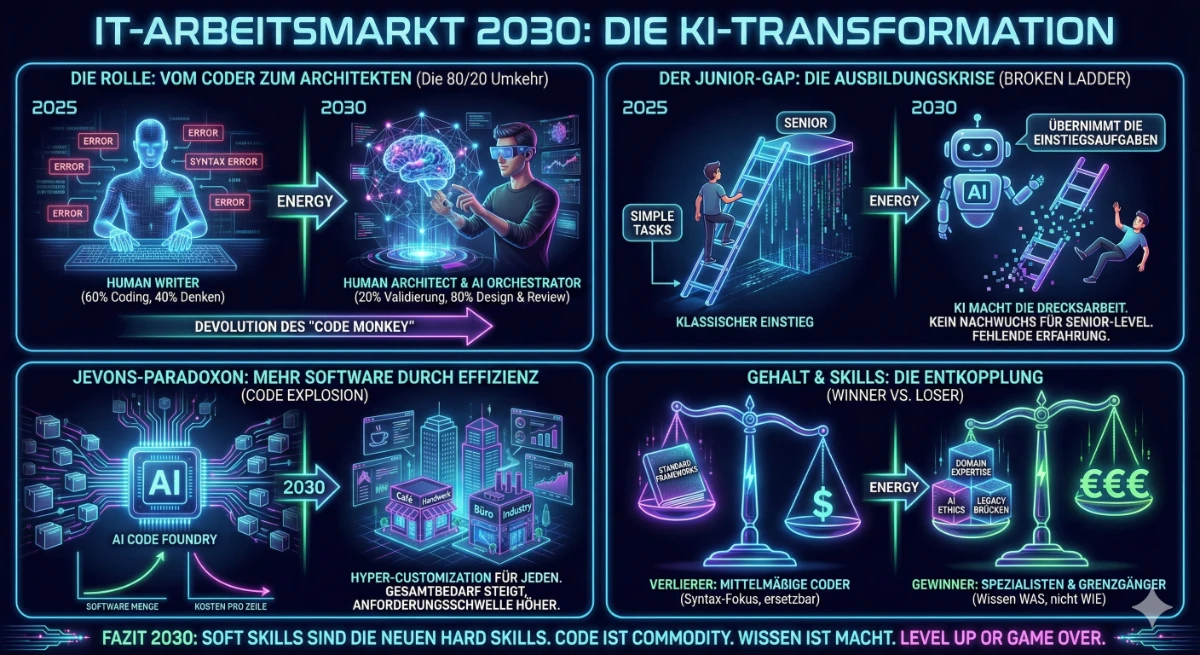

Der Junior-Level Freeze

Das Konzept des “Junior-Level Freeze” beschreibt eine strukturelle Diskontinuität im Arbeitsmarkt. KI-Systeme übernehmen zunehmend Aufgaben traditioneller Junior-Positionen: einfache Funktionen, Unit Tests, Dokumentation, Standard-Datenanalysen. Unternehmen substituieren Junior-Einstellungen, da ein Senior-Entwickler mit KI-Assistenz die Arbeit mehrerer Junioren erledigen kann.

Dies ist fundamental neu: Es betrifft nicht isolierte Jobverluste, sondern die Erosion des traditionellen Karrierepfads im White-Collar-Sektor. Der Mechanismus, durch den Berufsanfänger Erfahrung akkumulieren und sich für höhere Positionen qualifizieren, droht zu erodieren. Die langfristigen Konsequenzen für die Reproduktion von Expertise und Führungskräfteentwicklung sind bislang unkalkuliert.

Das Jevons-Paradoxon der Codierung

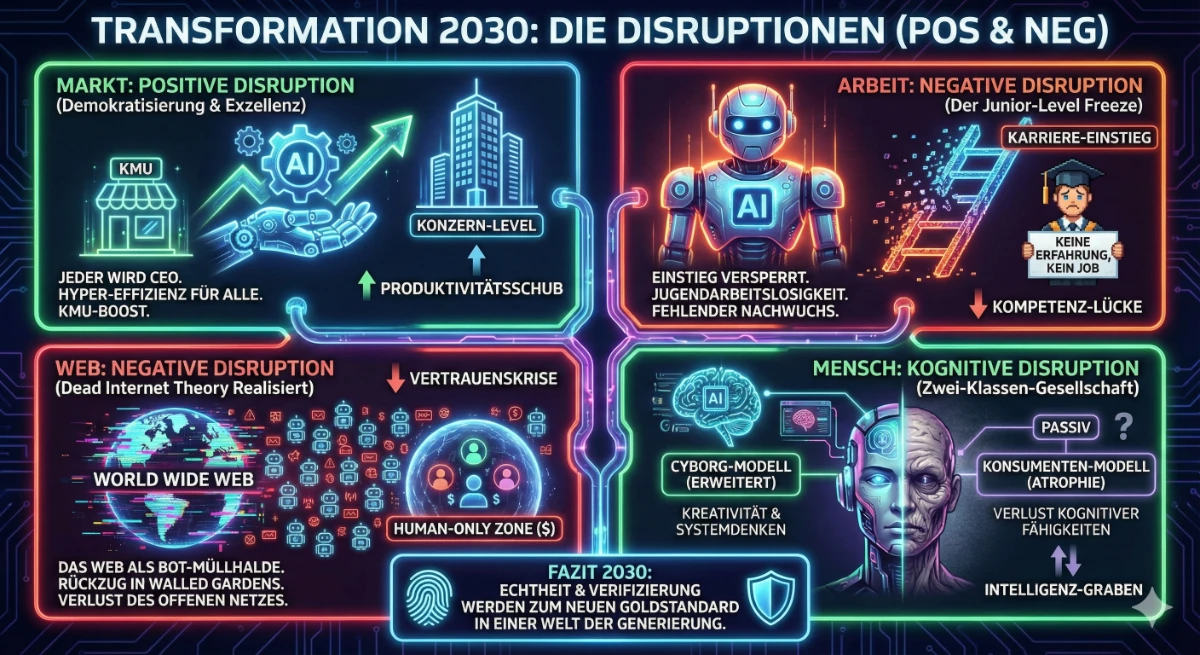

Führt das zur Massenarbeitslosigkeit unter Entwicklern? Nicht zwangsläufig. Hier greift das Jevons-Paradoxon : Wenn Softwareentwicklung drastisch billiger wird, explodiert nicht die Arbeitslosigkeit, sondern die Menge produzierter Software. Der Markt expandiert schneller als die Automatisierung substituiert.

Ein realistisches Szenario für nächsten Jahre ist z.B. die “Hyper-Customization”: Jeder Handwerksbetrieb, jede Abteilung erhält maßgeschneiderte Software-Lösungen. Der Markt benötigt keine reinen “Coder” mehr, die Funktionen abtippen, sondern “Produkt-Architekten” mit tiefem Domänenwissen, die diese Flut steuern und KI-Tooling-Erweiterungen orchestrieren.

Gleichzeitig manifestiert sich das Risiko einer gesellschaftlichen Bifurkation: Eine neue “Cyborg-Elite” nutzt KI effizienter, arbeitet kognitiv erweitert und ‘hybrid’, während andere Gruppen passivere Konsumenten werden und durch permanentes “Cognitive Offloading” Problemlösungskompetenzen verlieren.

Diese Spaltung hat auch ökonomische Dimensionen: Europäische Daten zeigen , dass jede Verdoppelung der regionalen KI-Innovation mit einem Rückgang der Lohnquote um 0,5-1,6% korreliert – die Produktivitätsgewinne fließen primär zu Kapitaleignern, nicht zu Arbeitnehmern.

Höhere Produktivität auf Basis neuer KI-Technologien führt somit nicht zwangsläufig zu allgemeiner Wohlstandserhöhung, aber auch nicht zwingend dazu, dass alle Jobs verschwinden, die Gesellschaft muss sich allerdings tiefer mit den bevorstehenden Transformationen und ihren Implikationen auseinandersetzen.

Die Rückkehr der Dezentralisierung: Edge AI und Open Source

Während Web 2.0 von einer Cloud-Doktrin dominiert wurde – zentrale Rechenzentren, proprietäre Plattformen, Datensammlung in Hyperscale-Infrastrukturen – vollzieht sich jetzt eine fundamentale Architektur- bzw. Infrastrukturverschiebung: Edge AI, lokale Verarbeitung und Open-Source-Modelle gewinnen massiv an Bedeutung. Ebenso der Ausbau von Rechenzentren auf lokaler Ebene.

Die Treiber sind klar: Datensouveränität und regulatorische Anforderungen können sich zum primären Adoptionsfaktor entwickeln. Während früher Latenz-Optimierung im Vordergrund stand, zeigen aktuelle Studien, dass Datenlokalisierung durch Souveränitätsbedenken zur Hauptmotivation für Edge-Deployment geworden ist. Gartner schätzt, dass bis 2025 75% aller Unternehmensdaten außerhalb traditioneller Rechenzentren und Cloud-Umgebungen entstehen – ein massiver Shift von zentralisierter zu verteilter Datenverarbeitung.

Der Markt wächst von $25,65 Milliarden (2025) auf projizierte $143 Milliarden (2034). Die Treiber: 97% der US-CIOs integrieren Edge AI in ihre Roadmaps, über die Hälfte neuer Modelle läuft bereits auf Edge-Devices – mit 30-40% Energieeinsparung und Latenzzeiten unter 10ms.

Entscheidend ist jedoch die Differenzierung: Diese Dezentralisierung betrifft primär spezialisierte, kleinere Modelle (3-13 Milliarden Parameter), nicht die Frontier Models. Modelle wie NVIDIAs Nemotron Nano (3,2B aktive Parameter) laufen auf Consumer-Hardware und liefern für viele Anwendungsfälle ausreichende Leistung. Selbst 70B-Modelle benötigen jedoch High-End-GPUs wie die H100 mit 80GB VRAM. Die größten Frontier Models (GPT-4-Klasse, vermutlich 1+ Trillion Parameter) bleiben praktisch unmöglich für lokale Deployments – sie erfordern Tausende vernetzter GPUs in Hyperscale-Rechenzentren.

Die strategische Pointe: Für die Mehrheit der Business-Anwendungsfälle – Dokumentenanalyse, Code-Assistenz, Kundenservice – sind die kleineren, edge-fähigen Modelle völlig ausreichend. Die Cloud-Abhängigkeit verschwindet dort, wo sie am kritischsten ist: bei sensiblen Daten und regulierten Industrien.

Parallel dazu etabliert sich ein florierendes Open-Source-Ökosystem: Mistral veröffentlichte 10 vollständig offene Modelle (3B-675B Parameter) unter Apache 2.0-Lizenz. Tools wie Ollama und LM Studio machen GPT-Klasse-Assistenten offline zugänglich. Die EU-KI-Verordnung begünstigt bewusst Open-Source-Modelle durch regulatorische Ausnahmen.

Das Paradigma verschiebt sich: Von “Cloud-First” zu “Edge-Native”, von proprietären Black Boxes zu transparenten, lokalen Modellen, von Datenextraktion zu Datensouveränität. Die Ironie der Geschichte: Die ursprüngliche Vision des dezentralen Internets kehrt zurück – diesmal nicht als Utopie, sondern als technische und regulatorische Notwendigkeit.

4. Strategische Imperative: Was jetzt zu tun ist

Diese Analyse ist kein theoretisches Glasperlenspiel. Sie führt zu harten, strategischen Konsequenzen für jeden Akteur der digitalen Wirtschaft.

Für Digitalagenturen: Der Tod der “Billable Hour”

Das klassische Agenturmodell (Zeit gegen Geld) steht vor dem Kollaps. Wenn eine KI eine mehrstündige Aufgabe in wenigen Minuten erledigt, ruiniert die Effizienz den Umsatz, wenn man nach Stunden abrechnet.

Mögliche Strategie: Radikaler Schwenk zu Outcome-Based Pricing (Bezahlung nach Ergebnis/Wert) oder “Service-as-a-Software”. Agenturen müssen Assets bauen, statt Zeit zu vermieten. Wer 2028 noch Stunden verkauft, wird ein Problem haben.

Für Entwickler: Vom “Maker” zum “Manager”

Der “Junior-Level Freeze” ist eine reale Gefahr: KI übernimmt die Aufgaben, an denen Berufseinsteiger früher gelernt haben (Testing, Doku, einfache Funktionen).

Teamstrukturen im Umbruch: Die klassische Zusammensetzung von Entwicklerteams (1-2 Seniors, 3-5 Mids, 2-3 Junioren) löst sich auf. Wir bewegen uns auf “Micro-Teams” zu: 2-3 hochspezialisierte Architekten orchestrieren KI-Agenten für Implementierungsarbeit. Die Produktivität pro Kopf steigt dramatisch – aber die Einstiegspositionen verschwinden. Die Konsequenz: Wer heute Junior ist, muss schneller in Richtung Spezialisierung wachsen, weil die “Lernphase durch Repetition” wegfällt.

Prozesse werden fluider: Starre Scrum-Sprints und detaillierte Backlog-Grooming verlieren an Bedeutung, wenn KI-Systeme Features in Stunden statt Wochen umsetzen. Die neue Herausforderung: Kontinuierliche Qualitätssicherung, Architektur-Reviews und “Prompt Engineering auf Organisationsebene” – das Definieren von Constraints und Zielen für autonome Code-Generierung.

Individuelle Karrierepfade: Die Spezialisierung verschiebt sich radikal. Relevante Skills 2028:

- Systemarchitektur und Integrationsdesign: Wie orchestriert man heterogene KI-Systeme?

- Security und Compliance: Wer validiert KI-generierten Code auf Sicherheitslücken?

- “Trust Engineering”: Wie baut man Verifikationspipelines für autonome Systeme?

- Domänenwissen: Ein “KI-augmentierter” Fintech-Spezialist ist wertvoller als ein generischer Full-Stack-Entwickler

Die strategische Frage für jeden Entwickler heute: Welches Wissen besitzt Du, das nicht in Trainingsdaten replizierbar ist? Die Aufgabe verschiebt sich vom Schreiben des Codes hin zur Verifikation der Wahrheit und zur strategischen Orchestrierung von Systemen.

Für Unternehmen: Sovereign AI – Die Flucht aus der API-Falle

Das “Leadership Gap” ist keine bloße Warnung mehr, es ist eine messbare Sicherheitslücke. Der Microsoft Work Trend Index 2024 zeigt: Während Führungskräfte zögern, nutzen 78% der KI-Anwender weltweit ihre eigenen Tools (“Bring Your Own AI”). Die Belegschaft wartet nicht auf Erlaubnis – sie kopiert Firmendaten in öffentliche Chatbots, um produktiv zu bleiben.

Die strategische Falle: Wer seine Wertschöpfung ausschließlich auf die APIs von US-Modellen (OpenAI, Anthropic) stützt, begeht einen strategischen Selbstmord auf Raten. Er macht sich zur austauschbaren Hülle (“Wrapper”) für die Technologie anderer. Wenn jeder Zugriff auf GPT-4 hat, bietet GPT-4 keinen Wettbewerbsvorteil mehr.

Der deutsche Sonderweg: Vom “Datenschatz” zum “Data Moat”

Deutschland hat einen entscheidenden Vorteil gegenüber dem Silicon Valley: Domänenwissen. Das Valley hat die Algorithmen, aber der deutsche Maschinenbau hat die Daten aus 50 Jahren Physik, Chemie und Produktion. Um diesen Vorteil zu nutzen, sind vier Schritte nötig:

Context is King (RAG & SLMs): Vergessen Sie das Training riesiger Modelle. Die Zukunft für die Industrie liegt in Small Language Models (SLMs) und Retrieval-Augmented Generation (RAG). Statt Firmendaten in eine Blackbox zu werfen, müssen Unternehmen ihre proprietären Daten (Wartungsprotokolle, CAD-Zeichnungen) als externe Wissensbasis anbinden, auf die eine KI zugreift. So bleiben die Daten im Haus, und die KI halluziniert weniger.

Kulturkampf: Six Sigma vs. Stochastik: Deutsche Ingenieurskunst basiert auf Determinismus – Input A führt zu 100% zu Output B. Generative KI ist jedoch probabilistisch (wahrscheinlichkeitsbasiert). Dieser kulturelle Schock ist das größte Hindernis. Unternehmen müssen lernen, KI dort einzusetzen, wo Kreativität und Synthese gefragt sind (Ideenfindung, Codedokumentation), und klassische Algorithmen dort behalten, wo Präzision (Maschinensteuerung) unabdingbar ist.

Die “Good Enough”-Revolution: In einer Welt, in der sich KI-Modelle alle sechs Monate in ihrer Leistung verdoppeln, ist der deutsche Hang zur Perfektion (“Over-Engineering”) ein Bremsklotz. Die neue Währung ist Iterationsgeschwindigkeit. Wer sechs Monate an einem Lastenheft schreibt, hat beim Projektstart bereits veraltete Technologie.

Souveränität durch Open Weights: Die Antwort auf die API-Abhängigkeit sind leistungsstarke offene Modelle (wie Llama oder Mistral), die auf eigenen Servern (“On-Premise”) oder direkt auf der Maschine (“Edge”) laufen. Das sichert nicht nur das geistige Eigentum, sondern reduziert auch Latenzzeiten in der Produktion.

Fazit: Die Frage ist nicht, ob deutsche Unternehmen KI nutzen. Die Frage ist, ob sie ihre Datenhoheit behalten. Wer seine Daten nur nutzt, um US-Modelle schlauer zu machen, wird zur verlängerten Werkbank der Hyperscaler. Wer seine Daten nutzt, um eigene, spezialisierte Modelle zu füttern, baut den einzigen Burggraben (“Moat”), der im KI-Zeitalter bestand hat.

5. Neue Schattenseiten

Ende des offenen Internets: AI Slop und menschenfreier Bot-Sumpf

Die “Dead Internet Theory” – ursprünglich 2019 als Verschwörungstheorie in obskuren Message Boards entstanden – klingt 2025 verstörend plausibel: Das Internet ist nicht mehr primär ein Ort menschlichen Austauschs, sondern eine von Bots, Algorithmen und synthetischen Inhalten dominierte Simulation.

AI Slop bezeichnet massenhaft generierte KI-Inhalte: Bilder, Videos, Texte, Musik – produziert für schnellen Konsum statt dauerhaften Wert. Plattformen wie Metas Vibes-Feed zeigen ausschließlich KI-generierte Bilder. OpenAIs Sora erzeugt täuschend echte Videos von Personen und Szenarien, die nie existierten. Die Grenze zwischen Realität und Synthese verschwimmt systematisch.

Das eigentliche Gift ist der Rückkopplungs-Effekt der Desinformation: KI-Modelle halluzinieren Fakten, erfinden Quellen, generieren gefälschte Zitate. Wenn diese Inhalte publiziert werden und viral gehen, werden sie zu Trainingsdaten für künftige Modelle. Die Lüge wird zur “Quelle” – der Kreislauf beschleunigt sich.

Konkrete Beispiele: Wikipedia stellte 2025 ein KI-Summary-Feature ein , nachdem die Community warnte, es könne “unmittelbaren und irreversiblen Schaden” für das Vertrauen anrichten. Forschung belegt , dass neuere Wikipedia-Einträge zunehmend KI-generierte Texte enthalten. Medienportale veröffentlichen KI-geschriebene Artikel, die professionell wirken, aber faktische Fehler oder erfundene Aussagen enthalten.

KI-gesteuerte Botnetze simulieren inzwischen ganze Diskussionen und erzeugen die Illusion öffentlichen Konsenses, obwohl keine echten Menschen beteiligt sind. Algorithmen belohnen Engagement – Slop ist darauf optimiert, Klicks und Reaktionen zu maximieren. Ohne aktive Unterdrückung wird synthetischer Content jeden Feed dominieren.

Die Konsequenzen sind systemisch, nicht nur qualitativ:

- Aufmerksamkeitsdiebstahl: Echter Diskurs wird von flachem Rauschen übertönt

- Normalisierung von Desinformation: Die Umgebung wird mit Falschinformation geflutet

- Tod der Originalität: Menschliche Kreative können nicht mit maschineller Skalierung konkurrieren

- Datenkollaps: Zukünftige Modelle trainieren auf fabrizierten Daten – qualitative Degeneration

Das Resultat: Rückzug in “Walled Gardens” – verifizierte Communities, Intranets, Paid Content. Für Marken bedeutet das: SEO verliert an Bedeutung, “Community Building” und echtes Vertrauen werden zur härtesten Währung. Wir verlieren nicht nur Qualität – wir verlieren das Signal im Rauschen.

AI SLOP 2 via Gemini

Die Singularitäts-Debatte: Verlieren wir die Kontrolle?

Doch die Korrosion der Wahrheit ist nur ein Symptom.

Die fundamentalere Frage dahinter: Verlieren wir die Kontrolle?

Ray Kurzweil prognostiziert die “Singularität” um 2045 – der Punkt, an dem KI die menschliche Intelligenz übertrifft. Diese Prognose bekräftigte er 2024 in “The Singularity is Nearer”. Der israelische Historiker Yuval Noah Harari warnt eindringlich: “Wir werden dann in der gleichen Position sein wie die Tiere. Wir werden wie das Pferd oder der Elefant sein, die nicht verstehen, was in der Welt geschieht.”

Die Gefahr ist real: die Forschung dokumentiert eine negative Korrelation zwischen der Häufigkeit der KI-Nutzung und der Fähigkeit zum kritischen Denken. Wenn wir systematisch Entscheidungsautonomie an Algorithmen delegieren, verkümmern die mentalen Fähigkeiten zur Analyse widersprüchlicher Informationen. Das Resultat: Eine Spaltung in eine “Cyborg-Elite”, die KI zur kognitiven Erweiterung nutzt, und eine passive Mehrheit, die das Denken outgesourct hat.

Die physische Rechnung: Energie und Klima

Die KI-Transformation ist kein rein digitales Phänomen – sie ist ein massiver physischer Kraftakt. Goldman Sachs schätzt , dass der Strombedarf von Rechenzentren in den USA bis 2030 von aktuell 4% auf über 8% des nationalen Gesamtbedarfs steigen könnte – eine Verdopplung in sechs Jahren.

Das Problem: Während wir über Dekarbonisierung sprechen, bauen wir eine Infrastruktur, die fossile Energiequellen reaktiviert. Das Risiko einer “Carbon Bubble” steigt. Green-IT ist kein PR-Thema mehr, sondern ein harter Kostenfaktor und ein regulatorisches Risiko. Wer 2030 keine nachweisbare Energieeffizienz vorweisen kann, wird von Investoren und Regulatoren abgestraft.

6. Geopatriation: Ein europäischer Sonderweg?

Angesichts dieser Szenarien – der US-amerikanischen Kommerzialisierung und der chinesischen Überwachung – stellt sich die Frage nach einer dritten Option.

Europa reagiert mit Regulierung (EU AI Act) und einer Tendenz zur “Geopatriation”: Gartner prognostiziert , dass bis 2030 über 75% der europäischen Unternehmen Workloads in souveräne, regionale Infrastrukturen zurückholen. Die EU AI Act-Compliance wird von Unternehmen als Qualitätssiegel für “vertrauenswürdige KI” positioniert.

Doch Regulierung allein ist keine Strategie. Wir müssen die Defizite schonungslos benennen: Europa ist abhängig bei Chips, Cloud und KI-Modellen. Um nicht zum digitalen Freilichtmuseum zu werden, sind vier Handlungsfelder entscheidend:

- Souveränität durch Infrastruktur: Wir können nicht auf US-Plattformen bauen und europäische Werte erwarten. Es braucht massive Investitionen in eigene Hardware- und Modell-Kapazitäten.

- Gesellschaftlicher Diskurs statt Nischendebatte: Die Digitalisierung darf nicht als technisches Nischenthema behandelt werden. Sie ist die zentrale soziale Frage unserer Zeit. Wenn bei Markus Lanz ein Digitalthema angeschnitten wird, ist Sascha Lobo der “Quoten-Digitale” – und damit ein Symptom dafür, wie unterrepräsentiert die Diskussion um die digitale Zukunft unserer alten Gesellschaft ist.

- Innovation mit Ethik: Der “European Way” muss beweisen, dass Wettbewerbsfähigkeit und ethische Standards (Privacy, Fairness) kein Widerspruch sind, sondern ein Qualitätsmerkmal für “vertrauenswürdige KI”.

- Antizipatorische Bildung: Wir müssen Bildungssysteme schaffen, die nicht Wissen vermitteln, das KI besser abruft, sondern Fähigkeiten stärken, die KI (noch) fehlen: Kontextverständnis, ethische Abwägung und komplexe Orchestrierung.

Schlussbetrachtung

Die Transformation der kommenden Jahre ist keine inkrementelle Weiterentwicklung, sondern eine systemische Reorganisation. Die Softwareentwicklung war der Kanarienvogel – was wir dort beobachten, blüht allen wissensbasierten Berufen: Erosion von Karrierepfaden, Substituierung durch Algorithmen, Disposable Assets.

Doch die entscheidende Frage ist nicht technologischer Natur – was KI leisten kann – sondern gesellschaftspolitisch: In welcher Gesellschaft wollen wir leben, wenn Algorithmen zu primären Akteuren werden? Eine Vision der Zukunft wie die des Global Village muss zurückerobert und neu sortiert werden. Der Handlungsbedarf besteht schon längst und so langsam sollten wir mal in die Pötte kommen.