Beyond Code: Vom Handwerk zur systemischen Orchestrierung

[Hinweis: Dieser Artikel ist eine Neufassung des ursprünglich auf productmonkey.de veröffentlichten Artikels “Softwareentwicklung in Zeiten von KI” und baut auf den dortigen Überlegungen auf.]

Beyond Code: Vom Handwerk zur systemischen Orchestrierung

Der Einsatz von KI verändert die Softwareentwicklung nicht nur – er definiert sie neu. Wir stehen kurz vor dem Kipppunkt, an dem global mehr Code maschinell generiert als manuell geschrieben wird. Wir erleben den Übergang von einer Ökonomie der Erstellung (Creation Economy) zu einer Ökonomie der Orchestrierung.

Die Konsequenz: Die Kosten für die reine Code-Produktion tendieren gegen Null, Entwicklungszyklen kollabieren auf Echtzeit und der Fokus verschiebt sich radikal vom „Wie“ (der handwerklichen Umsetzung) zum „Was“ (der Problemisolierung und Lösungsdefinition). Die Rolle des Software-Entwicklers steht damit vor ihrer größten Transformation: Generative KI und Agentic Workflows machen klassische Coding-Skills zur Commodity. Wer morgen relevant bleiben will, muss sich von der reinen Syntax lösen und interdisziplinäre Problemlösungskompetenz aufbauen.

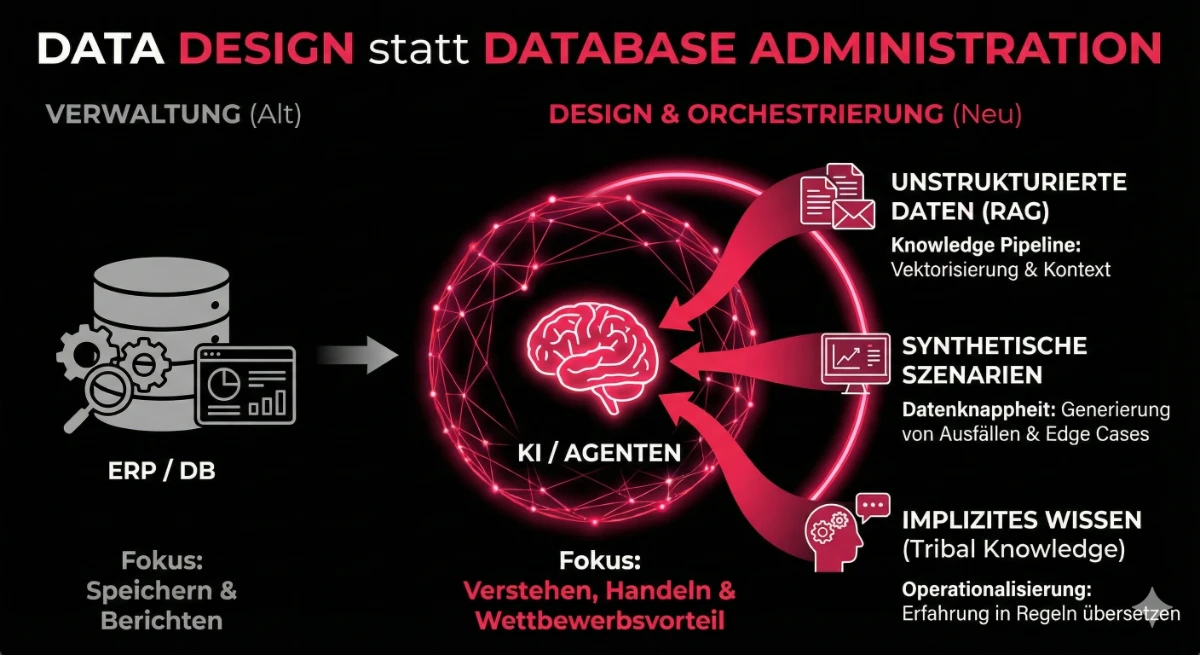

Gedankenspiel 1: Data Design statt Database Administration

Qualitativ hochwertige Daten waren schon immer wichtig, werden im Bereich von Modell-Feintuning, AI-Engineering und RAGs aber zur kritischen strategischen Ressource. Die Rolle des Datenverantwortlichen wandelt sich radikal: Wer zukunftsfähige Systeme baut, muss nicht mehr nur Datenbanktabellen verwalten und Backups fahren. Es müssen Daten-Ökosysteme designet werden, in denen KI-Agenten und -Anwendungen kontextsensitiv und wirtschaftlich sinnvoll operieren können.

Dabei ergeben sich neue Kernaufgaben, die weit über klassische Administration hinausgehen:

Vom “Data Lake” zur “Knowledge Pipeline”

Klassische ETL-Strecken haben Daten für Dashboards aufbereitet. Zukünftige Pipelines müssen Daten für autonome Agenten aufbereiten. Das bedeutet: Unstrukturierte Informationen (PDFs, Service-Berichte, E-Mails) müssen semantisch so angereichert und vektorisiert werden, dass diese für KI-Anwendungen nicht nur durchsuchbar sind, sondern auch verstanden werden können. Der “Data Designer” baut hier die Brücke zwischen roher Information und maschinellem Verständnis (RAG-Architekturen & Knowledge Graphs).

Die Antwort auf Datenknappheit - Synthetische Daten

Es herrscht oft die Meinung, man habe “zu wenig Daten” für KI. Das stimmt nicht immer komplett: Wir haben hierzulande häufig “Deep Data” – hochspezifisches Wissen, aber leider oft in zu geringer Stückzahl für klassisches Training. Hier wird das Synthetisieren von Daten zum Gamechanger. Wir benötigen Pipelines, die nicht nur bestehende Daten verarbeiten, sondern zusätzlich synthetische Szenarien valide entwerfen. Beispiel: Für die Entwicklung von KI-Agenten, die eine Produktionsanlage steuern sollen, warten wir nicht auf 1.000 reale Ausfälle. Wir generieren diese Ausfallszenarien synthetisch. Der Data Designer wird zum Szenario-Architekten, der der KI beibringt, wie sie in Situationen reagiert, die in der Realität noch nie eingetreten sind.

Implizites Wissen operationalisieren

Der wahre Schatz vieler Hidden Champions liegt nicht alleine in der ERP-Datenbank, sondern auch gerade in der Erfahrung aller Mitarbeiter. Data Design bedeutet somit auch, Prozesse zu schaffen, die dieses implizite Erfahrungswissen (“Wenn die Maschine so klingt, muss ich X tun”) in explizite, maschinenlesbare Regeln oder Trainingsdaten zu übersetzen. Wer es schafft, “Tribal Knowledge” in eine KI-Pipeline zu gießen, baut sich einen uneinholbaren Wettbewerbsvorteil, den kein generisches KI-Modell von der Stange kopieren kann.

Neue Aufgaben für das Data Design

Gedankenspiel 2: Das Ende der grafischen Oberfläche

KI verändern zunehmend auch die Nutzerinteraktion. Visuelle Interfaces (GUIs) haben bislang das Informationszeitalter dominiert, weil sie die Brücke zwischen menschlicher Intention und binärer Logik bildeten. Doch was passiert, wenn Maschinen unsere Sprache verstehen?

Wo früher Buttons geklickt wurden, genügt heute die Formulierung einer Absicht (Intent). Das Interaktionsdesign muss sich aus dem “visuellen Muff der 90er” befreien. Die Zukunft gehört Interface-agnostischen Erlebnissen, gesteuert durch Sprache, Gesten oder Kontext – orchestriert von KI, die das UI “on the fly” generiert. Dies bedeutet nicht, dass GUIs überflüssig werden, sondern dass sie flexibel und kontextabhängig erscheinen. Ein statisches Design weicht einer dynamischen, situativen Aufarbeitung von Information und Interaktion (z.B. durch Adaptive UIs). Mehr dazu hier im Blog .

Ein Wandel “on steroids”: Die Bifurkation der Entwickler

Die klassische Trennung zwischen Frontend- und Backend-Entwicklern wird sich auflösen. Wenn eine KI den kompletten Stack beherrscht, verändert sich das Benchmark drastisch. Wir beobachten eine historische Spaltung des Arbeitsmarktes:

- Die Krise der Junioren: Aufgaben, die traditionell dem Kompetenzaufbau dienten (Unit-Tests schreiben, einfache Komponenten bauen), werden automatisiert. Die Nachfrage nach reinen “Ausführungs-Codern” bricht ein.

- Der Aufstieg der AI & Workflow Engineers: Stattdessen entsteht eine enorme Nachfrage nach Ingenieuren, die existierende Modelle orchestrieren (AI Engineer) und autonome Systeme bauen können (Agentic Workflow Engineer).

Die Kernkompetenz verschiebt sich vom Schreiben deterministischer Befehle (If-Then-Else) hin zum Designen von “Action Loops”, in denen Agenten Aufgaben planen und ausführen. Das Debugging solcher nicht-deterministischer Systeme erfordert eher verhaltensanalytische als rein logische Fähigkeiten.

Die neue Rolle der Produktfunktionen: Manager des Unbekannten

Mit der Automatisierung der Code-Erzeugung verändert sich das Profil von Produktmanagern und Product Ownern dramatisch. Die Zeiten, in denen POs als “Ticket-Administratoren” fungierten, sind vorbei – diese Aufgaben übernehmen Tools und Lead Engineers.

Die Rolle entwickelt sich zum AI Product Manager. Der entscheidende Unterschied: Während klassische Software deterministisch ist (Input A = Output B), arbeiten KI-Produkte mit Wahrscheinlichkeiten. Der neue Produktmanager muss:

- Unsicherheit managen: Definieren, welches Fehlerniveau akzeptabel ist und wie das Produkt mit “Halluzinationen” umgeht.

- Daten-Strategie treiben: Verstehen, dass Daten kein Nebenprodukt, sondern das Produkt selbst sind.

- Ethik operationalisieren: Bias und Fairness-Checks sind keine Compliance-Übung mehr, sondern Core-Feature-Requirements.

Die neue Kernkompetenz ist die Qualitätssicherung der Intention. POs werden zu Co-Creators, die im Dialog mit der Maschine das Produkt in Echtzeit formen. Wer nur Backlogs verwaltet, wird automatisiert. Wer strategische Lücken zwischen Business-Value und technischer Machbarkeit schließt, wird unverzichtbar.

Wie sehen Entwicklungsteams von morgen aus?

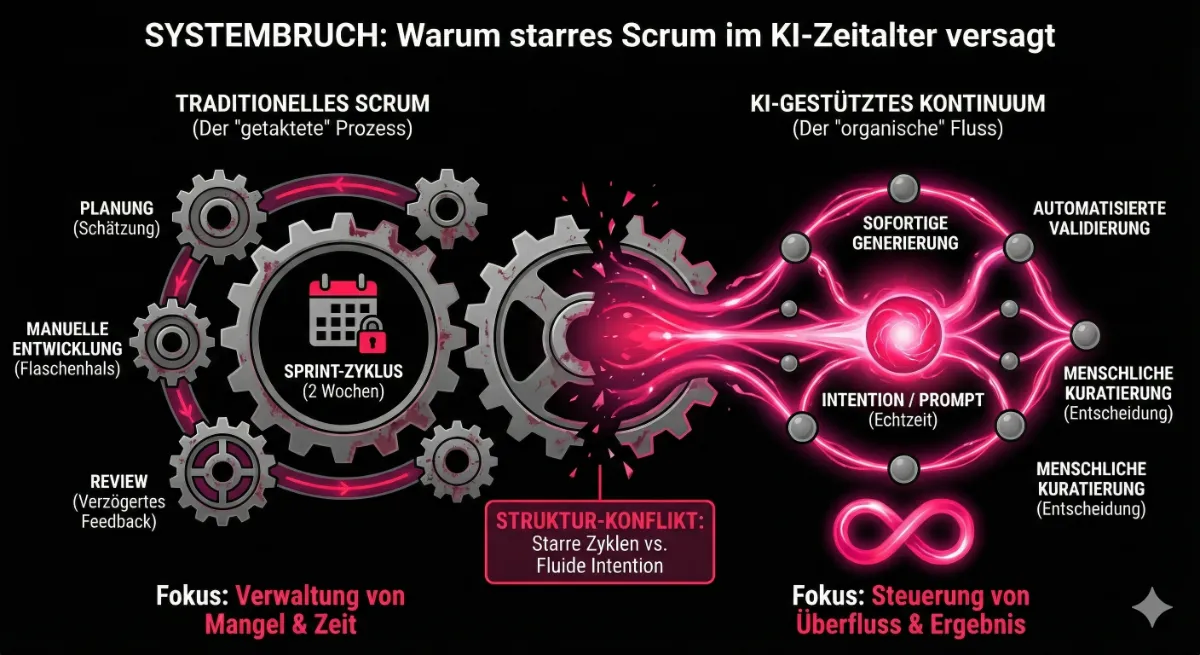

Software-Entwicklung wird weniger “Handwerker-Mentalität” und mehr “Regie-Arbeit” erfordern. Teams werden kleiner, agiler und insgesamt interdisziplinärer. Der Dialog mit generativer KI macht den Herstellungsprozess organischer: Es ist kein klassisches Abarbeiten von Listen mehr, sondern ein kontinuierliches Formen und Schleifen einer Lösung.

Neue Methoden für die organische Produktentwicklung

Zukünftige Teams müssen folgende Bereiche abdecken:

- Agentic Workflow Engineering: Das Entwerfen von Systemen, in denen mehrere KI-Agenten kollaborieren. Die Herausforderung liegt hier nicht in der Syntax, sondern in der Architektur der Entscheidungsketten.

- Die Kuratoren-Funktion: Da Code im Überfluss vorhanden ist, wird die Auswahl von Lösungen mit dem besten Fit entscheidend. Entwickler müssen präzise Anforderungen formulieren und das Ergebnis stetig auf Passung prüfen.

- Systemische Qualitätssicherung: Manuelle QA stirbt aus. Wir brauchen Strategien für “Agentic Testing” und synthetische User-Simulationen, um sicherzustellen, dass das Gesamtsystem stabil und sicher bleibt.

- Architektur statt Code-Review: Einen KI-generierten Code Zeile für Zeile zu reviewen, ist kognitiv kaum leistbar. Der Fokus muss auf der Architektur, Standards und der Vermeidung von “Tech Debt durch Automatisierung” liegen.

- Trust Design: UX-Designer gestalten nicht mehr nur Pixel, sondern Vertrauen. Wenn Software autonomer handelt, wird die “Explainability” (Warum hat der Agent das getan?) zum wichtigsten Design-Merkmal.

Fazit: Orchestrierung statt Abarbeitung

Der Einfluss von KI auf die Arbeitswelt ist kein temporäres Phänomen, sondern eine strukturelle Neusortierung des Wertes menschlicher Arbeit. KI eliminiert nicht die Notwendigkeit menschlicher Intelligenz, aber sie eliminiert die Toleranz für Mittelmäßigkeit in Routineaufgaben. Implizit macht dieser Wandel neue Rollen und Prozesse erforderlich, da sich vieles von einer festen Struktur in eine dynamische, adaptive Form verändert. Das bedeutet für Entwicklungsteams und Organisationen, dass wir uns auf eine neue Art der Zusammenarbeit einstellen müssen, die weniger auf reine Abarbeitung setzt und mehr auf Orchestrierung und strategische Beeinflussung von Wahrscheinlichkeiten in Echtzeit.

Drei konkrete Implikationen für die Zukunft:

- Talent-Strategie ändern: Da der Markt für Senior-KI-Talente leergefegt ist und Junior-Aufgaben häufig durch KI übernommen werden, müssen Unternehmen interne “AI Apprenticeship”-Programme schaffen. Wir müssen Junioren ganz anders fördern und für die Arbeitswelt der Zukunft vorbereiten, statt sie durch KI zu ersetzen.

- Polymath-Ingenieure fördern: Die Ära der Hyper-Spezialisierung auf reine Syntax (z.B. “Ich bin React-Entwickler”) schwindet. Der tiefere Wert liegt in der Breite: Daten verstehen, Architektur und Full-Stack-Entwicklung verstehen, Standards und Qualität stetig neu definieren, KI-Ethik verstehen und all dies zu einer Lösung verbinden.

- Prozesse entkernen: Scrum-Rituale, die nur der Status-Verwaltung dienen, müssen weichen. Die Geschwindigkeit der Code-Erzeugung erfordert fluidere, organische Prozesse, in denen Planung und Ausführung fast zeitgleich stattfinden. Dies wird ein Lernprozess für viele Organisationen darstellen und agile Werte sollten nicht über Bord geworfen werden. Ein kritisches Auge gegenüber überflüssigen Prozessen ist erforderlich, ebenso wie die Fähigkeit, die Organisation mit neuen, flexiblen Strukturen schnell anzupassen.

Auch interessant in diesem Kontext: